INHOUDSOPGAWE:

- Outeur Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:42.

- Laas verander 2025-01-22 17:14.

Versamel (Aksie) - Gee al die elemente van die datastel terug as 'n skikking by die bestuurderprogram. Dit is gewoonlik nuttig na 'n filter of ander bewerking wat 'n voldoende klein subset van die data terugstuur.

Op hierdie manier, wat is PySpark?

PySpark Programmering. PySpark is die samewerking van Apache Spark en Python. Apache Spark is 'n oopbron-kluster-rekenaarraamwerk, gebou rondom spoed, gebruiksgemak en stroomanalise, terwyl Python 'n algemene, hoëvlak-programmeertaal is.

Ook, wat is kaart in PySpark? Vonk Kaart Transformasie. A kaart is 'n transformasie-operasie in Apache Spark. Dit is van toepassing op elke element van RDD en dit gee die resultaat as nuwe RDD terug. Kaart transformeer 'n RDD van lengte N in 'n ander RDD van lengte N. Die inset- en uitset-RDD's sal tipies dieselfde aantal rekords hê.

Op hierdie manier, wat is SparkContext in PySpark?

PySpark - SparkContext . Advertensies. SparkContext is die toegangspunt tot enige vonk funksionaliteit. Wanneer ons hardloop enige Vonk toepassing, 'n bestuurderprogram begin, wat die hooffunksie en jou SparkContext word hier geïnisieer. Die drywerprogram voer dan die bewerkings binne die eksekuteurs op werkernodusse uit.

Hoe kan ek die PySpark-weergawe nagaan?

2 Antwoorde

- Maak Spark Shell Terminal oop en voer opdrag in.

- sc.version Of vonk-submit --version.

- Die maklikste manier is om net "spark-shell" in die opdragreël te begin. Dit sal die.

- huidige aktiewe weergawe van Spark.

Aanbeveel:

Wat is die indeks wat vir veelvuldige velde in MongoDB gebruik word?

Saamgestelde indekse

Wat is die eenheid wat gebruik word om die spoed van data-oordrag te meet?

Die spoed waarmee data van een toestel na 'n ander oorgedra kan word. Datakoerse word dikwels gemeet in megabis (miljoen bisse) of megagrepe (miljoen grepe) per sekonde. Dit word gewoonlik onderskeidelik afgekort as Mbps en MBps. Nog 'n term vir data-oordrag is deurvloei

Wat is 'n tydvertragingsaflos wat 'n RC-tydkringbaan gebruik?

Nuwer ontwerpe van tydvertragingsrelais gebruik elektroniese stroombane met resistor-kapasitor (RC) netwerke om 'n tydvertraging te genereer, en aktiveer dan 'n normale (oombliklike) elektromeganiese aflosspoel met die elektroniese stroombaan se uitset

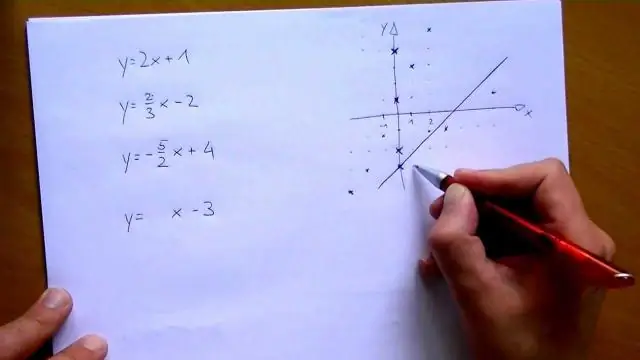

Hoe maak ek 'n PySpark DataFrame uit 'n lys?

Ek volg hierdie stappe om 'n DataFrame uit 'n lys tupels te skep: Skep 'n lys tupels. Elke tupel bevat naam van 'n persoon met ouderdom. Skep 'n RDD uit die lys hierbo. Skakel elke tupel om na 'n ry. Skep 'n DataFrame deur createDataFrame op RDD toe te pas met behulp van sqlContext

Wat is ry in PySpark?

'n Ry in SchemaRDD. Die velde daarin kan soos eienskappe verkry word. Ry kan gebruik word om 'n ry voorwerp te skep deur benoemde argumente te gebruik, die velde sal volgens name gesorteer word